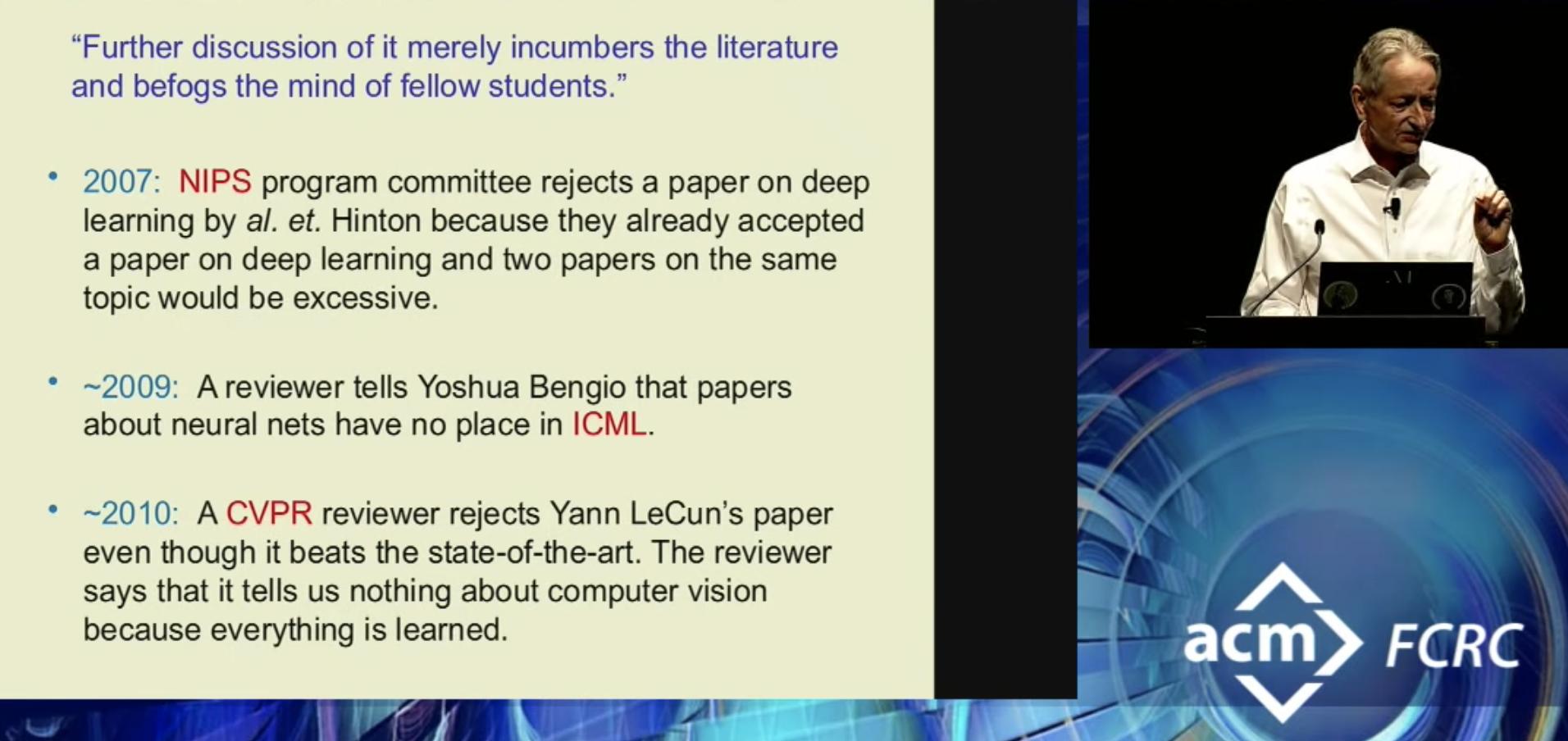

Некоторые причины для отказа в публикации статей, которые получали награждённые в этом году премией имени Алана Тьюринга Geoffrey Hinton, Yoshua Bengio и Yann LeCunn (все трое учёных, в принципе, и так уже давным давно заработали себе такие имена, что для них эта награда практически ничего не значит. Мой любимый Хинтон так и вовсе по рассказам периодически ворчит что-то вроде: "да уже достали с этими премиями, дали б лучше поработать спокойно")

(красным указаны названия конференций, места на которые нонче выкупаются за ~11 минут с момента начала продажи - так было с NIPS)

Отдельно доставляет последний пункт. В начале 20 века так говорили про физику. Ничего не меняется... Люди, в общем, тоже.

(красным указаны названия конференций, места на которые нонче выкупаются за ~11 минут с момента начала продажи - так было с NIPS)

Отдельно доставляет последний пункт. В начале 20 века так говорили про физику. Ничего не меняется... Люди, в общем, тоже.